6 Minuty

Společnost OpenAI představila GPT-5-Codex-Mini, kompaktní a cenově optimalizovanou variantu svého kódovacího modelu poháněného GPT-5, navrženou tak, aby vývojářům nabízela dostupnější přístup k pokročilému generování kódu a asistenci při softwarovém inženýrství. Tento menší model cílí na týmy a jednotlivce, kteří potřebují škálovat automatizaci vývoje bez dramatického nárůstu provozních nákladů, a zároveň využít moderní techniky strojového učení pro refaktoring, generování testů nebo rychlé prototypování funkcí.

What the new mini model offers

GPT-5-Codex-Mini je menší, nákladově optimalizovaný sourozenec modelu GPT-5-Codex. Je navržen tak, aby poskytoval většinu klíčových kódovacích schopností — například generování nových projektů, přidávání funkcí a testů, rozsáhlé refaktory a asistenci při řešení chyb — a to při výrazném snížení výpočetních nákladů. Díky menší reálné náročnosti na GPU a optimalizovaným inference cestám umožňuje Mini provozovat zhruba čtyřikrát více požadavků ve srovnání s plnou verzí GPT-5-Codex za stejný rozpočet, přičemž podle OpenAI dochází pouze k mírnému poklesu přesnosti a složitějšího deduktivního uvažování.

Pro praktické aplikace to znamená, že týmy mohou lépe alokovat vysokokapacitní modely na kritické úlohy (např. bezpečnostní analýzy, návrh architektury, komplexní ladění výkonu) a přesunout rutinní, opakující se nebo vysoce objemové práce (např. generování scaffoldingu, masová tvorba testovacích sad, refactoring podle vzorů) právě na Mini. Tato strategie „vícepoddělkového“ využití modelů vede k optimalizovanému poměru cena/výkon a umožňuje rychlejší iterace v rámci kontinuální integrace (CI) a kontinuálního nasazení (CD).

How it performs: real benchmark numbers

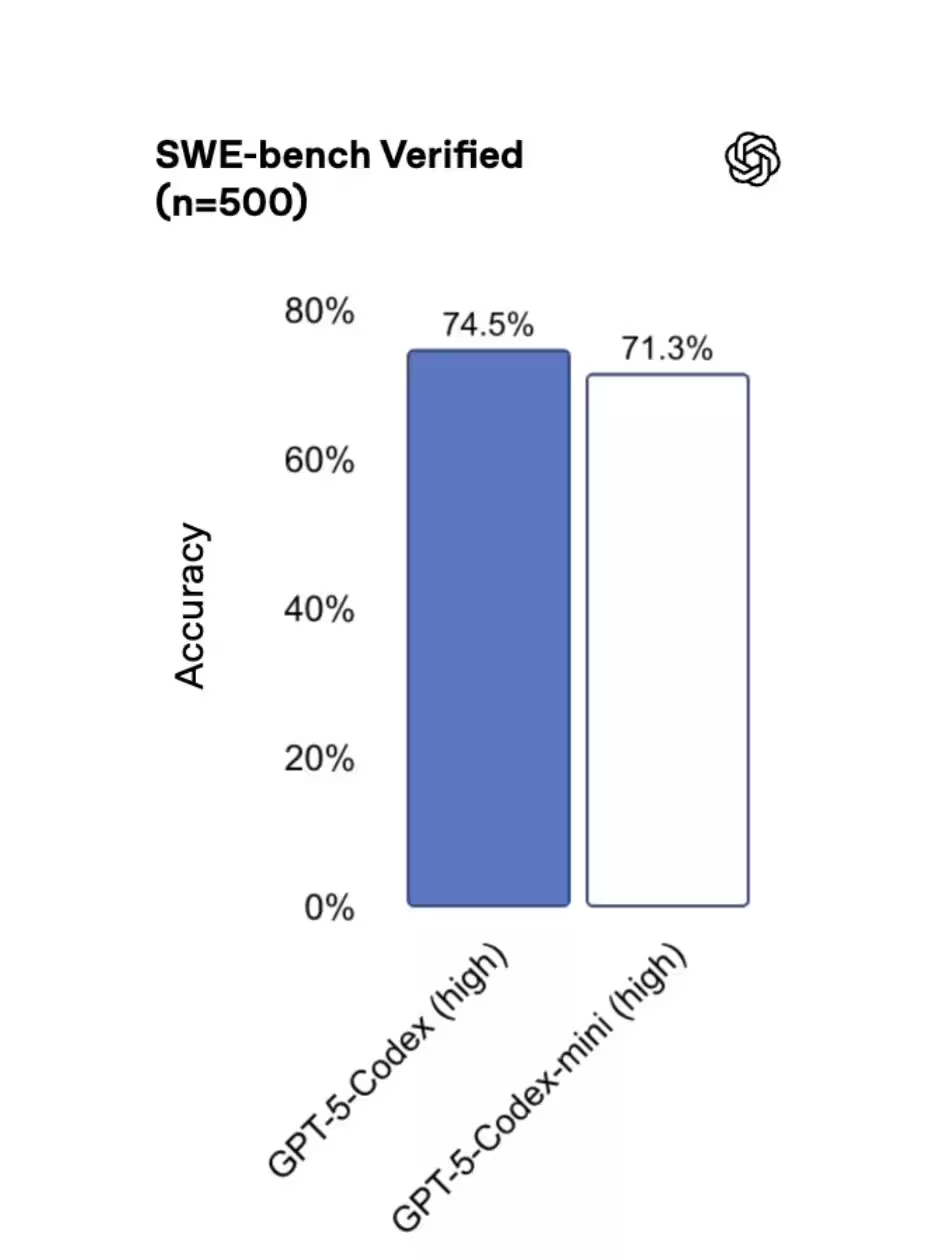

Benchmarky na sadě SWE-bench Verified ukazují, že tři modely jsou si velmi blízké: GPT-5 High dosáhl 72,8 %, GPT-5-Codex 74,5 % a GPT-5-Codex-Mini skončil na 71,3 %. Tyto výsledky naznačují, že Mini si uchovává značnou část silných stránek původního modelu a zároveň přináší měřitelné úspory nákladů — což je atraktivní kompromis pro mnoho produkčních workflow.

Je však důležité kontextualizovat čísla. Benchmarky jako SWE-bench ověřují generalizované schopnosti modelů v řadě úloh softwarového inženýrství (syntéza kódu, opravy chyb, psaní testů, návrhy API). V reálných projektech záleží výsledná užitečnost modelu také na integrační vrstvě: prompt designu, předzpracování dat, post-processingových filtrech, CI/CD integrační logice a monitorování latence a přesnosti. Proto doporučujeme provést interní A/B testování na reprezentativních repozitářích a pracovních scénářích před plošným nasazením.

Konkrétní doporučení pro měření výkonu v praxi zahrnují: vyhodnocení přesnosti generovaných změn proti sadu referenčních oprav, měření počtu ručních zásahů vývojářů po automatickém refaktoringu, sledování flakiness generovaných testů a měření dopadu na čas nasazení (time-to-deploy). S těmito metrikami bude zřejmé, kdy Mini přesně odpovídá požadavkům na kvalitu a kdy je vhodné přepnout na plný Codex nebo GPT-5 High pro kritické, bezpečnostně citlivé či architektonicky složité úlohy.

When developers should pick the Mini

Kdy je tedy Mini správná volba? OpenAI doporučuje používat GPT-5-Codex-Mini pro méně náročné inženýrské úkoly nebo jako záložní řešení, když se blížíte k limitům používání primárního modelu. Nástroje Codex dokonce navrhují přepnout na Mini, jakmile dosáhnete přibližně 90 % svého kvótového limitu. Představte si Mini jako „plynový pedál“ pro průmyslové workflow: nechte na plném modelu úlohy s vysokou důležitostí a přesuňte rutinní nebo vysokoopakovací části práce na Mini, abyste maximalizovali průtok a minimalizovali náklady.

Konkrétní scénáře, kde dává smysl nasadit Mini, zahrnují:

- Hromadné generování boilerplate kódu nebo šablon pro nové moduly a mikroslužby.

- Automatické doplňování unit testů a integračních testů na základě existujícího API kontraktu.

- Pravidelné refaktory typu „finding-and-replacing patterns“ (např. modernizace zavedených design patternů, aktualizace závislostí, odstranění deprekovaného API usage).

- Předběžné návrhy řešení při code review, které vývojář potom ověří a dolaďuje.

Na druhou stranu úlohy vyžadující hluboké logické uvažování, komplexní matematické analýzy, nebo situace s přímým dopadem na bezpečnost a soulad s regulacemi by měly zůstat na výkonnějších variantách. Dále doporučujeme kombinovat Mini s kvalitním layerem validace — například statickou analýzou, testovacími sadami a lidským review — aby byla zajištěna konzistence a bezpečnost výsledného kódu.

Where you can use it today

Mini je již dostupný v rozhraní příkazové řádky (CLI) a jako plugin pro populární IDE, přičemž podpora API je plánována v krátkodobém horizontu. To znamená, že vývojáři ho mohou okamžitě integrovat do lokálních pracovních postupů, CI pipeline a do editorů pro asistované psaní kódu — a to ještě před širším rozšířením API.

Praktické možnosti nasazení zahrnují:

- Integrace do CI/CD: spouštění automatických refaktorů a testovacích generátorů v rámci build pipeline, aby se minimalizoval manuální zásah a zrychlilo nasazení.

- IDE pluginy: inline asistence při psaní kódu, návrhy změn, generování komentářů a návrhy testů přímo v prostředí vývojáře (VSCode, JetBrains atd.).

- CLI nástroje: skriptovatelné volání modelu pro dávkové úlohy, migrace kódu nebo auditní skripty, které lze plánovat přes cron/CI.

- Lokální pracovní postupy: kombinace modelu s nástroji pro statickou analýzu, linting a bezpečnostní skenery pro předběžné schvalování změn.

Dobrá praxe při integraci Mini do existujících nástrojů zahrnuje definování explicitních politik pro fallback (kdy přepnout z Codex na Mini), monitorování metrik kvality kódu po automatizovaných změnách a nastavení alertů pro případ, že automatizovaný krok sníží pokrytí testů nebo zvýší počet bezpečnostních varování.

Behind the scenes: performance and reliability upgrades

OpenAI také oznámila infrastrukturní vylepšení, která mají zajistit předvídatelnější používání Codexu. Práce na efektivitě GPU a optimalizacích směrování (routing) umožnily OpenAI zvýšit limity rychlosti (rate limits) o 50 % pro předplatitele ChatGPT Plus, Business a Education. Zákazníci s plány Pro a Enterprise mají navíc prioritu zpracování, což pomáhá udržet špičkovou rychlost a odezvu při vysokém zatížení.

Dřívější problémy způsobené caching chybami, které snižovaly použitelnou kapacitu, byly také řešeny, takže vývojáři by měli zaznamenat stabilnější a spolehlivější zkušenost v průběhu dne. Kromě toho jsou nasazeny metriky a telemetrie, které pomáhají sledovat latenci, chybovost a poměr úspěšných generací, což umožňuje rychlejší iterace a ladění nasazení v produkci.

Ze strany architektury se doporučuje kombinovat modely s robustními orchestrace vrstvami — například s frontami zpráv, retry logikou, fallback strategiemi a canary nasazeními. To snižuje riziko náhlého poklesu dostupnosti nebo degradace kvality a dává týmům možnost postupně rozšiřovat využití Mini bez narušení kritických služeb.

Bottom line: GPT-5-Codex-Mini poskytuje týmům praktický způsob, jak škálovat automatizaci kódování bez úměrného nárůstu nákladů. Pro mnohé vývojáře bude rozumnější volbou pro úlohy s vysokým objemem nebo s nižším rizikem — obzvláště dokud OpenAI pokračuje v rozšiřování přístupu k API a zpřísňování garancí výkonu. Pokud je strategicky nasazen jako součást vícevrstvého přístupu (kombinace Mini + plný Codex/GPT-5 High), může výrazně zrychlit time-to-market a snížit operativní náklady při zachování přijatelné kvality výsledného softwaru.

Zdroj: smarti

Zanechte komentář