6 Minuty

Samsung se profiluje jako jeden z hlavních dodavatelů pamětí pro další generaci AI serverů společnosti Nvidia a slibuje dodat přibližně polovinu nových modulů SOCAMM2 DRAM, které bude Nvidia v roce 2026 potřebovat. Tento krok navazuje na rok intenzivního dolaďování high‑end DRAM a HBM produktů v Samsungu, během něhož společnost zlepšila výrobní výtěžnost a optimalizovala výkon paměťových čipů pro datacentra a akcelerátory umělé inteligence.

Proč je vítězství Samsungu v oblasti SOCAMM2 důležité

Po tom, co Samsung v loňském roce z větší části zmeškal prudký nárůst poptávky po pamětech pro AI, společnost zintenzivnila své úsilí a dosáhla znatelného zlepšení výtěžnosti a parametrů na svých pokročilých DRAM linkách. Samsung již odeslal vzorky HBM4 společnosti Nvidia pro závěrečné testování a nyní oficiálně potvrdil záměr dodat přibližně 50 % modulů Small Outline Compression Attached Memory Module 2 (SOCAMM2), které Nvidia očekává v příštím roce. To je signál pro trh pamětí i pro provozovatele datacenter, že dodavatelský řetězec směrem k AI infrastrukturám začíná získávat lepší rovnováhu mezi poptávkou a nabídkou.

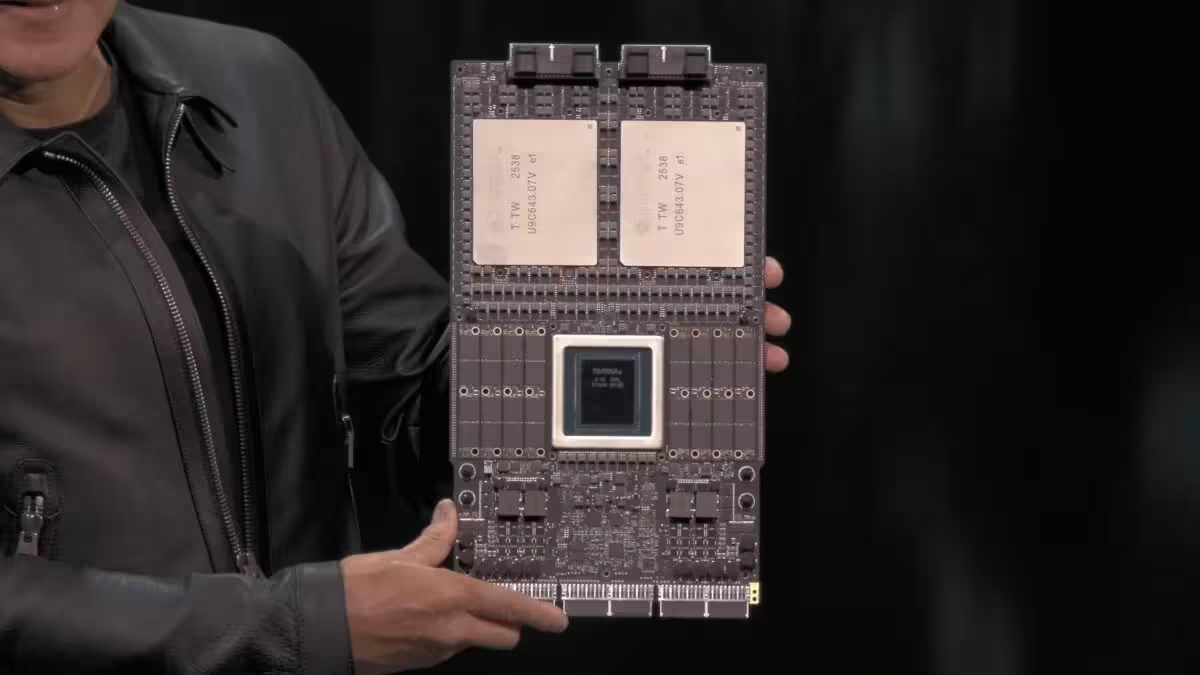

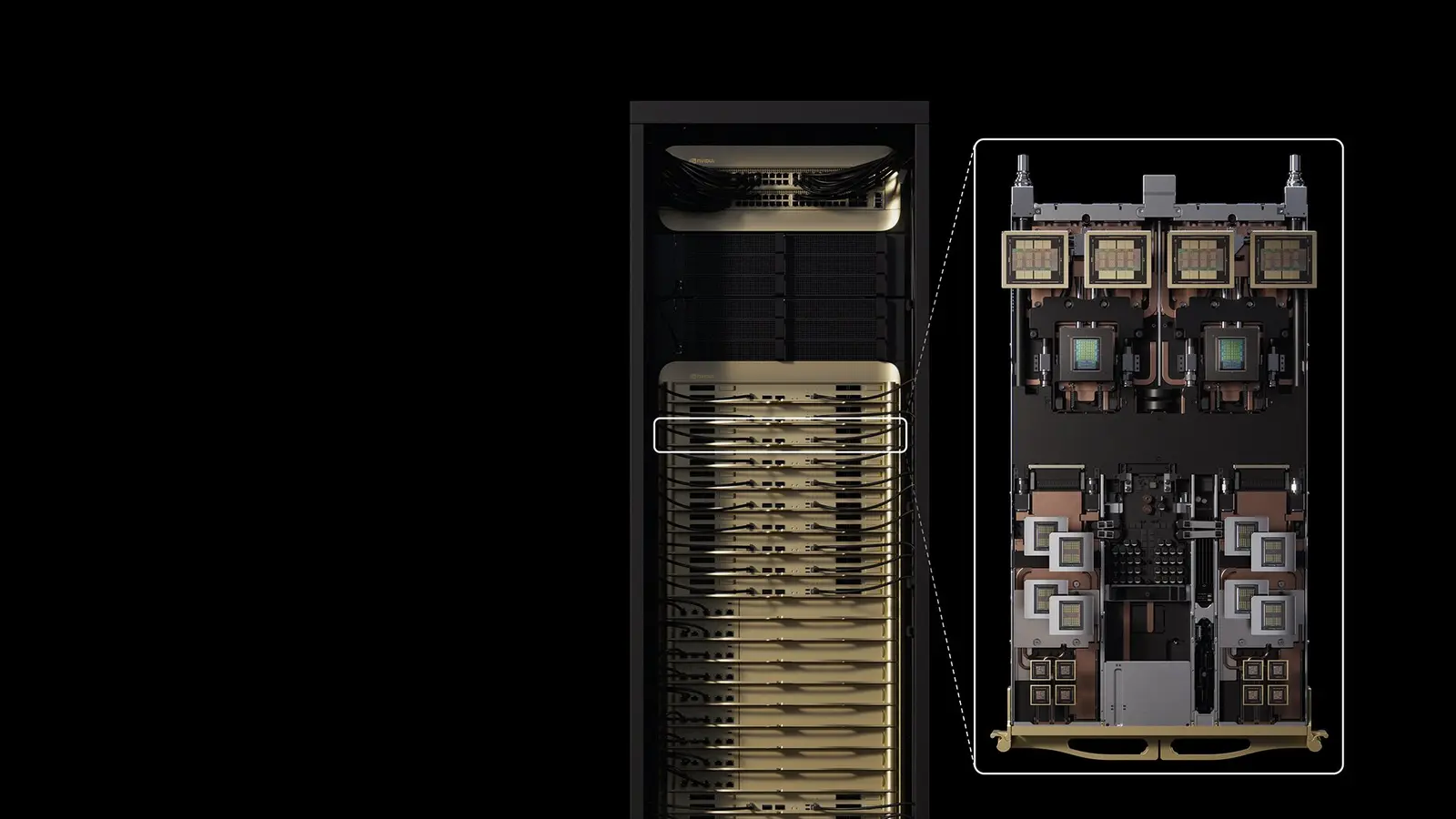

SOCAMM2 představuje v praxi hustší a serverově optimalizovaný balík paměti, který konsoliduje více LPDDR čipů na jediném substrátu. Taková integrace usnadňuje upgrade a údržbu serverů a současně zlepšuje hustotu paměti a energetickou efektivitu pro AI datacentra. V platformách Nvidie, jako jsou Vera servery, jsou vedle procesu Vera CPU umisťovány několikanásobné moduly SOCAMM2, které zásobují GPU řady Rubin daty s velmi vysokou propustností a nízkou latencí. To umožňuje výkonným akcelerátorům efektivněji zpracovávat velké modely strojového učení, trénovat je a nasazovat inference v produkčním prostředí.

V letošním roce vedla v úvodním nástupu na trh SOCAMM společnost Micron, nicméně Samsung spolu se SK Hynix zvýšily své kapacity a technologickou úroveň. Samsung uvádí, že stabilizoval výtěžnost u svých páté generace 1c DRAM čipů, které tvoří základní stavební kameny pro moduly SOCAMM2, což mu umožňuje škálovat výrobu a lépe plánovat dodávky. Stabilita výtěžnosti je klíčová nejen pro splnění objemových požadavků Nvidie, ale i pro udržení konkurenceschopných cen a zajištění kvality v dravém prostředí poptávky po pamětech pro AI servery.

Z technického hlediska jsou SOCAMM2 moduly navrženy tak, aby maximalizovaly poměr kapacity k ploše serverového šasi a minimalizovaly energetické ztráty spojené s přenosem dat. Použití LPDDR5X čipů v konfiguraci 24Gb umožňuje dosáhnout vyšších hustot a současně udržet latence, které jsou pro AI trénink a inference kritické. Kompresní mechanismy a optimalizované rozhraní mezi modul a řadičem paměti jsou dalším aspektem návrhu SOCAMM2, díky kterým lze dosahovat lepšího využití šířky pásma v prostředí, kde je paralelní zpracování dat zásadní.

Pro provozovatele cloudových služeb, hyperscalery a poskytovatele AI infrastruktury představuje dostupnost spolehlivých a škálovatelných paměťových modulů jako SOCAMM2 možnost rychlejšího rozšiřování kapacit pro velké modely. To ovlivňuje rozhodování o návrhu serverových platforem, investicích do výpočetní infrastruktury a celkové strategii nasazení akcelerátorů. Z pohledu Nvidie, která orchestruje návrh svých platform Vera a Rubin, je klíčové mít spolehlivé dodavatele, kteří dokážou garantovat objemy a kvalitu v plánovaných časových rámcích.

Škála a nabídka: konkrétní čísla a dopady na trh

Podle dostupných informací Nvidia požádala výrobce pamětí, aby dodali až 20 miliard gigabajtů (GB) modulů SOCAMM v rámci svých plánů pro masivní rozšíření AI infrastruktury. V současném uspořádání by Samsung pokryl přibližně polovinu této kapacity, tedy zhruba 10 miliard GB. Aby Samsung dosáhl takové úrovně dodávek, odhaduje, že bude potřebovat přibližně 830 milionů 24Gb LPDDR5X DRAM čipů. To se přibližně přepočítává na 30 000–40 000 waferů měsíčně, což představuje zhruba 5 % měsíční produkce DRAM waferů celkově v Samsungu.

Tyto objemy mají významné implikace pro plánování výrobních linek, alokaci kapacit v továrnách a řízení zásob surovin. Výroba waferů zahrnuje složité fáze litografie, depozice, etchování a testování, přičemž každá dodatečná požadovaná kapacita má dopad na fronty výrobních procesů i dostupnost nemocných komponent. Z pohledu dodavatelského řetězce je potřeba koordinovat kapacity několik měsíců, někdy i rok dopředu, aby se zajistilo plynulé naplnění poptávky bez prudkých fluktuací cen nebo zpoždění distribuce.

Micron a SK Hynix by měly pokrýt zbývající poptávku po SOCAMM2 modulech, čímž by se trhu mělo podařit dosáhnout potřebné kapacity. Pro Samsung znamená zajištění velké části dodávek SOCAMM2 spolu s potenciálními objednávkami HBM4 výrazný růst tržeb a ziskovosti v období, kdy investice do AI infrastruktury nabírají na tempu. HBM4, jako vysoce výkonná vysokopásmová paměť, může dále zvýšit průměrnou prodejní cenu a marže u serverových konfigurací, kde je cílem maximální propustnost pro akcelerátory velkých modelů.

Očekávané dopady na ceny se odvíjejí od více faktorů: od výrobních nákladů a výtěžnosti čipů přes konkurenci mezi hlavními hráči (Samsung, Micron, SK Hynix) až po poptávkový tlak ze strany velkých odběratelů jako Nvidia a hyperscalerů. Při dostatečné nabídce a stabilní výtěžnosti je pravděpodobné, že ceny budou relativně stabilní nebo se budou mírně snižovat díky ekonomice rozsahu. Naopak, pokud se vyskytnou nečekané problémy ve výrobě nebo logistice, může to vést ke krátkodobým nárůstům cen, které se promítnou do nákladů na budování AI klastrů.

Z technické perspektivy je důležité také sledovat proces validace HBM4 u Nvidie. Dokončení těchto testů a schválení by znamenalo, že Samsung může rozšířit svůj balík řešení pro AI servery nejen o SOCAMM2, ale i o vysoce výkonné HBM4 paměti, které jsou klíčové pro velmi náročné výpočty a modely vyžadující extrémní šířku pásma. Validace zahrnuje komplexní testy kompatibility, teplotní stabilitu, životnost a chování při vysokých zatíženích — faktory rozhodující pro nasazení v produkčních datacentrech.

Co tedy očekávat dál? Pravděpodobné je širší zavádění SOCAMM2 v serverech určených pro AI, jakmile dodavatelé navýší kapacity a stabilně pokryjí požadavky Nvidie a dalších výrobců. Sledujte také vývoj v oblasti HBM4 a jejího schvalovacího procesu u Nvidie a dalších partnerů — výsledek bude mít přímý vliv na dodavatelské řetězce pamětí a na cenovou dynamiku v roce 2026. Dalším faktorem, který stojí za pozornost, je to, jak si konkurenti rozdělí zbývající trh a jak bude vypadat technologická diferenciace v rámci SOCAMM2 modulů, například v otázkách spotřeby energie, tepelného managementu, chybovosti a kompatibility s různými platformami.

Pro výrobce serverů a provozovatele cloudových služeb je klíčové plánovat migrační strategie, které zohlední dostupnost SOCAMM2 a HBM4, aby bylo možné plynule navyšovat kapacity bez zásadních změn v architektuře serverů. Pro koncové uživatele a vývojáře AI to znamená postupné zlepšení výkonu a škálovatelnosti aplikačních služeb, rychlejší trénink modelů a efektivnější nasazení inferenčních služeb díky vyšší dostupné propustnosti pamětí a nižší latenci mezi CPU a GPU komponentami.

Souhrnně lze říci, že angažmá Samsungu v dodávkách přibližně poloviny SOCAMM2 pro Nvidii a současné úsilí o uvedení HBM4 do výroby představují důležitý milník pro trh pamětí pro AI. Pokud se podaří naplnit sliby o kapacitě a kvalitě, může to urychlit nasazení robustních a vysoce výkonných serverových platforem pro umělou inteligenci a vytvořit stabilnější ekosystém dodavatelů paměťových řešení v letech 2026 a dál.

Zdroj: sammobile

Zanechte komentář