7 Minuty

Americký startup podporovaný fondem Gates Frontier Fund Billa Gatese představil experimentální AI procesor, který místo elektronů využívá světlo. Společnost Neurophos uvádí, že její optický čip může přinést výrazné zlepšení výkonu a energetické účinnosti, čímž nabízí alternativní cestu pro škálování umělé inteligence mimo tradiční silikony a GPU. Tento krok otevírá nové možnosti pro návrh akcelerátorů strojového učení a má potenciál přenastavit metriky výkonu versus spotřeba energie v datových centrech.

Od elektronů k fotonům: jiný způsob výpočtu

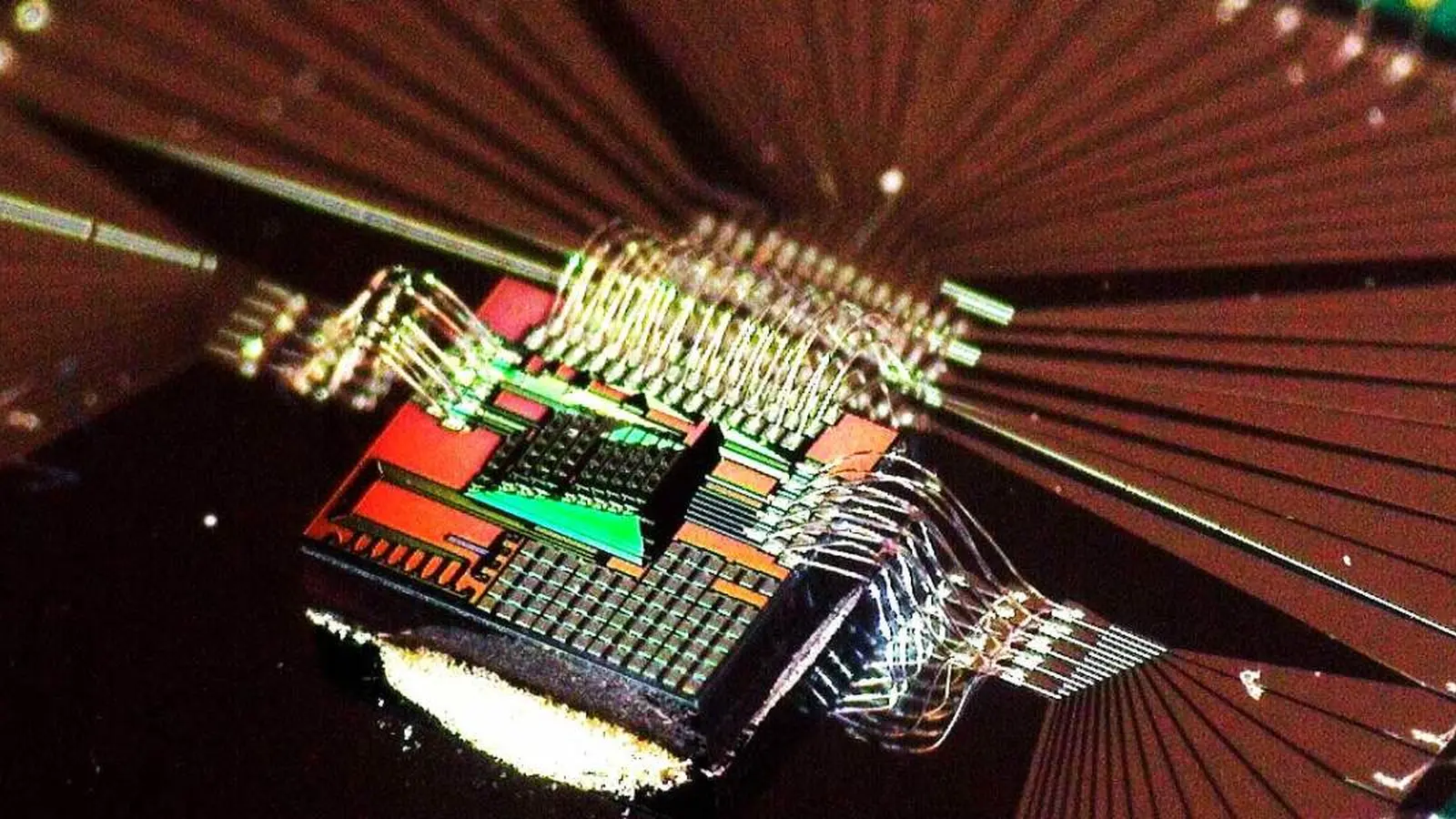

Místo posílání elektronů přes tranzistory Neurophos navrhuje provádět výpočty pomocí fotonů. Světlo mění stav rychleji a produkuje daleko méně tepla než pohyb nábojů v křemíku, což teoreticky umožňuje mnohem vyšší propustnost a nižší spotřebu energie. Optické přepínače a modulátory mohou fungovat s nižší latencí a umožnit paralelní zpracování signálů pomocí interferenčních a vlnovodových struktur. To je zvlášť zajímavé pro operace, které dominují v neuronových sítích — tedy velké maticové násobení.

Neurophos tvrdí, že překonalo zásadní překážku optických výpočtů tím, že zmenšilo optické komponenty na hustotu kompatibilní se stávajícími továrnami na čipy. To znamená, že místo spoléhání se na mnoho menších elektronických jader lze na křemíku umístit jedinou velmi velkou optickou výpočetní matici. Integrace optických prvků do procesu výroby (foundry-compatible photonics) je klíčová pro průmyslové nasazení — umožňuje využít existující výrobní kapacity a snižuje technologické riziko spojené s úplně novými výrobními postupy.

Technicky to zahrnuje návrh vlnovodů, fotodetektorů, modulátorů a fází řízených elementů na úrovni, která minimalizuje ztráty a šum. Optické systémy často pracují analogově, což přináší výzvy v oblasti přesnosti, kalibrace a opakovatelnosti výsledků. Řešení těchto problémů obvykle vyžaduje sofistikované algoritmy pro kompenzaci chyb, adaptivní řízení intenzity světla a hybridní architektury kombinující optické a elektronické bloky tam, kde je potřeba digitální přesnost nebo složitá logistika dat.

Co to znamená ve srovnání s dnešními čipy pro AI

Nvidia a další výrobci GPU stále zakládají základní matematiku AI na elektronických obvodech. Nvidia do svých systémů integruje fotoniku převážně za účelem zrychlení mezikusové komunikace (interconnect), například při propojování serverů nebo akcelerátorů, ale samotné aritmetické operace pořád provádějí elektrony. To platí i pro řadu dalších akcelerátorů, včetně TPU, specializovaných ASIC a mnoha typů FPGA řešení.

Neurophos cílí na skutečné optické výpočty, kde fotony vykonávají základní maticové operace používané v neuronových sítích. Pokud bude tomuto přístupu dosaženo při srovnatelné přesnosti a přijatelné výrobní ceně, může to zásadně proměnit kompromisy mezi výkonem a spotřebou energie, které datová centra dnes řeší. Pro provozovatele to může znamenat dramatické snížení nákladů na chlazení a na napájení, zvlášť u rozsáhlých inferenčních clusterů, které běžně běží 24/7.

Klíčové rozdíly je možné shrnout i z hlediska architektury a softwaru: optické matice mohou provádět paralelní analogové násobení a sčítání (MAC) s velmi nízkou energetickou náročností na operaci, ale potřebují nový přístup k mapování neuronových vrstev, kvantizaci vah a korekci chyb. Softwarové toolchainy, kompilátory a optimalizátory pro GPU jsme vyvíjeli desítky let; přechod na optiku bude vyžadovat obdobnou soustředěnou práci na vrstvách od frameworků přes kompilátory až po runtime plánovače.

- Rychlejší přepínací rychlosti: fotony mohou měnit svůj stav rychleji než elektrony, což umožňuje vyšší „hodinové“ frekvence u některých typů operací.

- Nižší generování tepla: menší odpadní teplo snižuje potřebu chlazení a zlepšuje energetickou efektivitu pro rozsáhlé inferenční nebo tréninkové systémy.

- Hustší výpočetní plocha: jedna velká optická matice může zjednodušit pohyb dat na čipu ve srovnání s mnoha distribuovanými jádry.

Reality check: velké překážky přetrvávají

Přes smělá prohlášení čelí Neurophos dlouhodobé inženýrské výzvě dříve, než bude možná sériová výroba. Optické komponenty se chovají jinak než tranzistory: jejich parametry závisí na vlnové délce, polarizaci, fázi a přesném fyzikálním uspořádání vlnovodů. To znamená, že návrh, simulace a testování musí zohlednit jiné sady fyzikálních jevů než tradiční CMOS logika. Navíc analýza odolnosti vůči rušení a variability výrobního procesu je kritická pro zajištění opakovatelnosti výsledků ve výrobě.

Softwarová infrastruktura rovněž potřebuje zásadní práci. Kompilátory musí umět převést výpočty neuronových sítí na instrukce pro optickou matici, zohlednit analogové chování a navrhnout schémata kalibrace a korekce. Validace výsledků na úrovni modelů, benchmarků a systémových testů je nutná, aby provozovatelé datových center důvěřovali optickým akcelerátorům pro produkční nasazení.

Další složitý aspekt je integrace s existujícími datovými centry: rozhraní pro napájení, chlazení, fyzické rozměry modulů, komunikace s hostitelskými servery a softwarová kompatibilita s ekosystémem (např. Kubernetes, frameworky jako TensorFlow nebo PyTorch) musí být řešena. Spolehlivost a odolnost vůči poruchám při provozu v rozsahu od jednotek po tisíce modulů je neprůstřelným požadavkem, který vyžaduje dlouhodobé testování a monitorování.

I přesto, že technologie není bez rizik, podpora ze strany Gates Frontier Fund a šuškanda v odvětví — původně popsáno serverem Tom's Hardware — naznačují rostoucí zájem o alternativy ke škálování omezenému křemíkem. Představa, že energeticky náročné inferenční regály nahradí kompaktní optické moduly s výrazně nižší spotřebou a tepelným výstupem, už nevypadá tak nedosažitelně: startupy jako Neurophos tento scénář postupně přibližují.

Kdo vyhraje závod o čipy?

Nvidia zůstává dominantním hráčem a pravděpodobně bude trhu dominovat ještě roky díky zralosti ekosystému, podpoře softwaru a výrobnímu měřítku. Její produkty, knihovny (např. CUDA) a rozsáhlá síť softwarových partnerů jí dávají výraznou konkurenční výhodu. Nicméně optické výpočty by se mohly stát silnou komplementární technologií: specializované optické akcelerátory by mohly být optimalizovány pro inferenci nebo pro konkrétní velké maticové úlohy, zatímco elektronické GPU by zůstaly preferovanou volbou pro univerzální trénink a zajištění kompatibility.

V praxi je méně důležité, zda Nvidia „padne“, a více to, jak se celý ekosystém hardware pro AI bude vyvíjet. Photonika má potenciál přeuspořádat metriky výkonu a spotřeby v horizontu příští dekády: otázkou zůstává tempo adopce, průlom v řešení výrobních výzev a schopnost dodavatelů ekosystému dodat nástroje a služby pro hladké zavedení těchto technologií do provozu.

Současně se očekává, že na trhu vznikne několik paralelních přístupů: hybridní moduly kombinující optickou matici pro masivní paralelní MAC operace s elektronickými řadiči pro řízení, korekce a méně nativní výpočty; dedikované optické boxy pro inferenci v okrajových datových centrech s důrazem na nízkou spotřebu; a specializovaná řešení pro určité domény (např. zpracování signálu, určité typy transformátorových matic), kde optika nabídne jasné výhody.

Pro investory a provozovatele datových center bude důležitá jediná věc: poměr nákladů k přínosům. Pokud optické systémy nabídnou významné snížení TCO (total cost of ownership) při přijetí bez nepřijatelného zvýšení rizika, můžeme očekávat rychlejší přijetí. Pokud budou vyžadovat rozsáhlé změny v infrastruktuře a softwaru bez okamžitého ekonomického přínosu, adopce bude pomalejší a technologii si osvojí nejprve specializovaní hráči s vysokou citlivostí na energetické náklady.

Z dlouhodobého hlediska je realistické, že fotonické výpočty doplní stávající křemíkové GPU a další akcelerátory místo jejich nahrazení. Kombinace různých architektur — elektronické, fotonické i další specializované — by mohla vést k heterogenním datovým centrům, kde různé úlohy běží na optimální platformě podle metrik jako spotřeba energie, latence, cena za operaci a požadovaná přesnost modelu.

Zdroj: gizmochina

Zanechte komentář