8 Minuty

Úvod

Tým výzkumníků z Apple se rozhodl položit jednoduchou, ale znepokojivou otázku: co vlastně reální uživatelé očekávají od AI agentů, když jim tito agenti pomáhají s běžnými úkoly? Odpověď není uklidňující ani jednotná. Je neuspořádaná, lidská a plná kompromisů.

Studie a cíle výzkumu

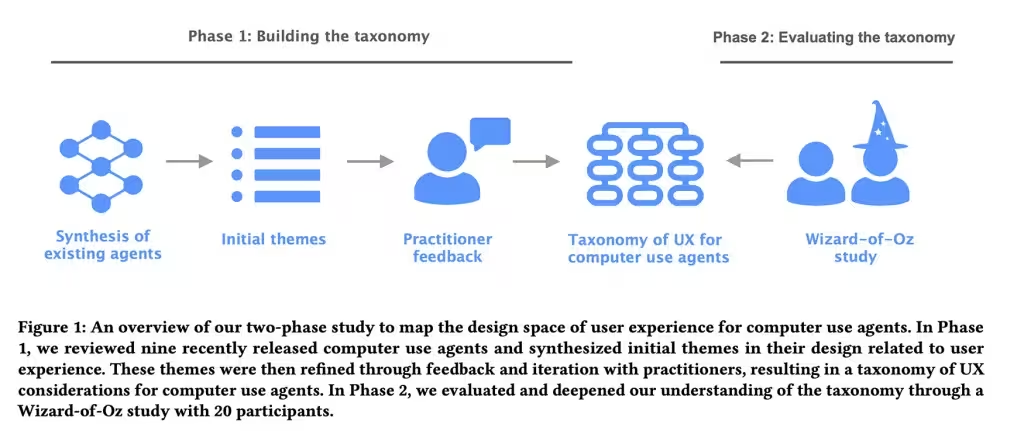

V práci nazvané Mapping the Design Space of User Experience for Computer Use Agents vědci zmapovali devět existujících agentů — názvy jako Claude Computer Use Tool, Adept, OpenAI Operator, AIlice, Magentic-UI, UI-TARS, Project Mariner, TaxyAI a AutoGLM — aby pochopili, jak tyto systémy prezentují své schopnosti, jak řeší chyby a jak nabízejí kontrolu uživateli. První fáze byla observační a klasifikační: osm odborníků na uživatelskou zkušenost (UX) a umělou inteligenci shrnulo krajinou do čtyř hlavních kategorií, 21 podkategorií a 55 konkrétních návrhových vlastností.

Tyto vlastnosti pokrývaly široké spektrum otázek — od toho, jak uživatelé zadávají vstupy agentu, přes transparentnost jeho akcí, až po to, jakou kontrolu si uživatelé zachovávají a jak jsou formovány jejich mentální modely a očekávání. Cílem bylo identifikovat konkrétní designové volby, které ovlivňují důvěru, efektivitu a použitelnost při běžných úkonech, jako je rezervace dovolené nebo nákup online.

Metodika: Wizard of Oz experiment

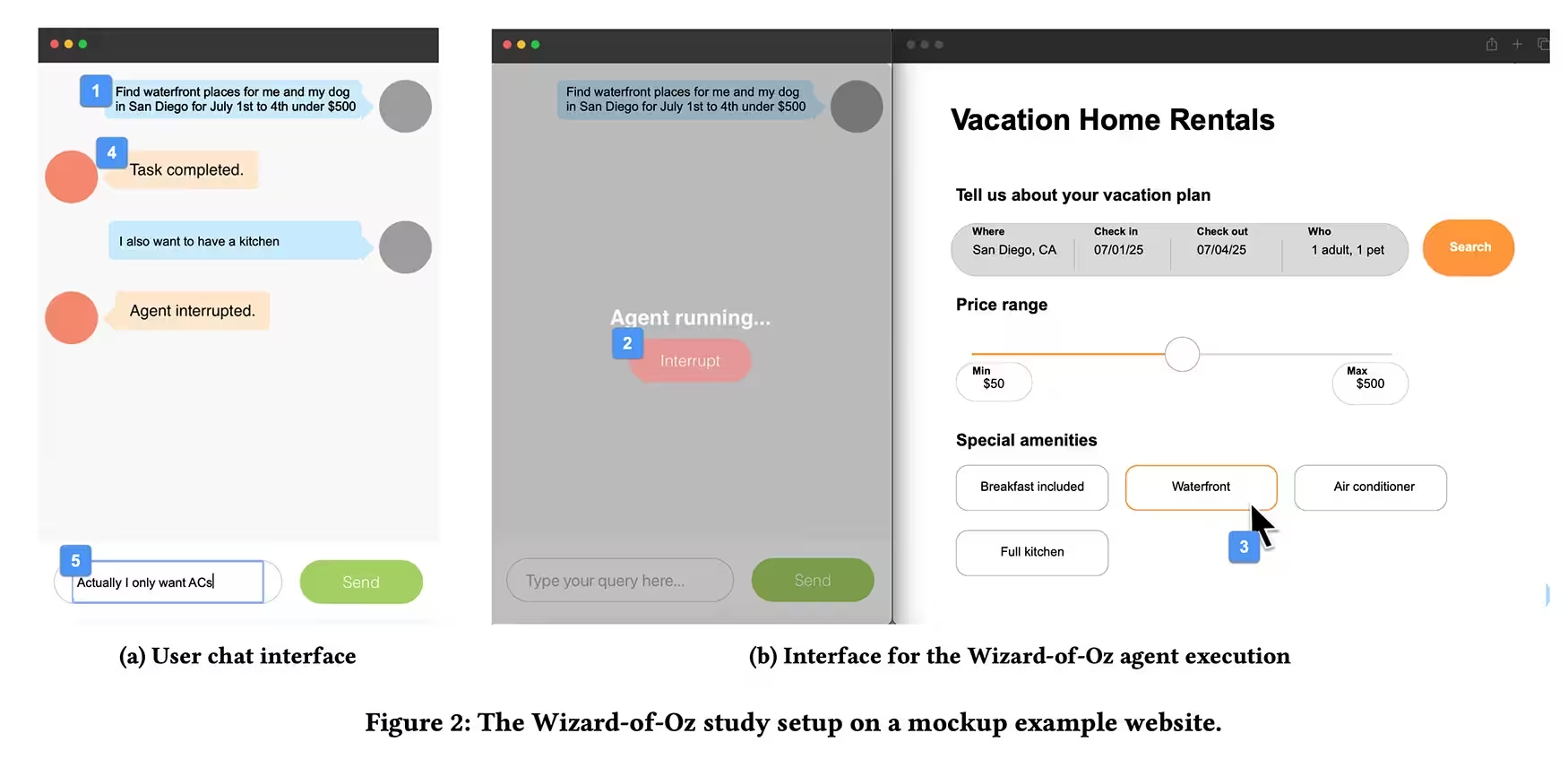

Poté tým spustil takzvaný „Wizard of Oz“ experiment. Dvacet účastníků s předchozí zkušeností s AI asistenty bylo požádáno, aby delegovali úkoly — například rezervaci dovolené nebo nákup produktu přes internet — přes rozhraní připomínající chat, zatímco výzkumník skrytě ovládal agenta pomocí klávesnice a myši. Účastníci mohli psát příkazy a použít tlačítko pro zastavení, které přerušilo agenta.

Některé úkoly byly záměrně narušeny chybami nebo neočekávanými přerušením, aby výzkumníci mohli pozorovat, jak lidé reagují, když agent udělá chybu nebo učiní předpoklad, který není v souladu s uživatelovým záměrem. Tato metoda umožnila sledovat přirozené reakce uživatelů v situacích, které simulují reálné používání, aniž by experimentátor skutečně využíval plně autonomní model. Díky tomu vědci získali vhled do emocionálních a behaviorálních reakcí — například do toho, kdy uživatelé přeruší agenta, kdy vyžadují vysvětlení, a kdy agentovu činnost přijmou bez další kontroly.

Hlavní zjištění

Ze studie se vynořil jasný vzorec: lidé chtějí mít přehled o tom, co agent provádí, ale nechtějí mikromanagement každého kliknutí. Krátké demonstrace a příležitostná potvrzení uživatele uklidňují. Úplné mlčení agenta vyvolává podezření. Náhlá automatizace bez vysvětlení má podobný efekt. Začátečníci touží po krok za krokem vysvětleních a měkkých kontrolních bodech, zejména tam, kde mají akce konkrétní důsledky — nákupy, změny v účtech nebo jakékoli kroky, které nejdou snadno vrátit zpět.

Naopak odborníci preferují, aby agent jednal spíše jako důvěryhodný kolega než jako přehnaně opatrný asistent. To znamená méně potvrzení, rychlejší průběh akcí a větší důraz na efektivitu než na podrobné vysvětlování. Tento rozdíl v preferencích naznačuje, že ideální agent by měl dynamicky upravovat míru transparentnosti a kontroly podle úrovně zkušeností uživatele a podle rizikovosti úkolu.

Důvěra: křehká, ale klíčová

Studie ukazuje, že důvěra se chová jako sklo: křehká a snadno praskne. Skryté předpoklady nebo drobné chyby erodují důvěru rychleji, než plynulý výkon dokáže důvěru budovat. Když agent vybočí z očekávaného postupu nebo narazí na nejednoznačnost, účastníci preferovali, aby agent pozastavil akci a položil otázku, místo aby odhadoval a jednal. Tato preference přetrvávala i tehdy, když dodatečné potvrzení působilo mírně otravně — lepší bezpečnost než pozdější škoda, jak uživatelé naznačovali.

Důraz na pauzy, dotazy a čitelné stavy (state visibility) vychází z potřeby uživatele udržet si mentální model toho, co se děje. To zahrnuje jednoduché, ale klíčové prvky UX: indikátory průběhu, jasné logy akcí, možnost vrátit krok zpět nebo zastavit probíhající činnost a stručné vysvětlení důvodu navrhované akce. Pozornost k těmto detailům je důležitější než jenom vylepšení samotných modelů — je to o navrhování interakcí, které lidem dávají pocit kontroly a porozumění.

Praktické doporučení pro designéry a vývojáře

Návrhové AI agenty přizpůsobte tak, aby upravovali míru transparentnosti a kontroly podle povahy úkolu a úrovně zkušeností uživatele. To je hlavní doporučení, které z výzkumu plyne prakticky okamžitě. Níže jsou doporučení přeložená do konkrétních návrhových pravidel a vzorů chování, které lze přímo implementovat v rozhraních a pracovních postupech:

- Ukazujte záměr a postup: Používejte krátké náhledy akcí (preview), vizuální průběžné ukazatele a stručné souhrny kroků, které agent provede. To snižuje nejistotu bez nutnosti mikromanagementu.

- Možnost rychlého přerušení: Zajistěte viditelné a spolehlivé tlačítko „zastavit“ a jednoduché způsoby, jak upravit nebo vrátit nedávné akce.

- Stupňovitá komunikace: Přizpůsobte množství vysvětlení podle „stavu“ uživatele (nováček, pokročilý, expert) a podle závažnosti úkolu (informativní, rizikový, nereverzibilní).

- Soft confirmy: Namísto konstantních potvrzení používejte selektivní, kontextově podložené dotazy — například potvrzení jen u nákupů, změn nastavení účtu nebo akčních kroků s vysokou prioritou.

- Transparentní chybové zprávy: Když dojde k chybě, vraťte srozumitelnou informaci o tom, proč k ní došlo, jaký je navrhovaný následující krok a jak uživatel může chybu opravit.

Implementační vzory

Několik konkrétních vzorů, které podporují výše uvedená doporučení:

- Progressive Disclosure (postupné odhalování): Zobrazte stručné shrnutí akce s možností rozbalit podrobnosti. Začátečník si rozbalí více informací, expert zůstane u stručného souhrnu.

- Contextual Confirmations (kontextová potvrzení): Potvrzení pouze tam, kde je to relevantní — například při platbě nebo změně údajů. Minimalizuje to frikci u běžných úloh.

- Explainable Steps (vysvětlitelné kroky): Při vykonávání vícekrokových úloh zobrazte, jaké kroky jsou dokončeny, které probíhají a jaký bude další krok; to posiluje mentální model uživatele.

Role uživatelského profilu

Agent by měl dálkově nebo lokálně přizpůsobit své chování na základě jednoduchého profilu uživatele: zkušenosti, tolerance k riziku, preference notifikací a historii interakcí. Například profil „expert“ může implicitně snížit frekvenci potvrzení a zvýšit rychlost vykonávání akcí, zatímco profil „nováček“ zapne více vysvětlení, bezpečnostních kontrol a možností ručního schvalování.

Technické poznámky a měření

Zavádění těchto vzorů vyžaduje i technické prvky a metriky, aby bylo možné iterovat na základě tvrdých dat. Doporučené metriky zahrnují:

- Čas na dokončení úkolu (Task Completion Time)

- Míra přerušení (Stop / Interrupt Rate)

- Míra vrácení kroků (Rollback Rate)

- Sledování důvěry (Trust Signals) přes uživatelské ankety a opakované používání

- Sledování chyb a jejich dopadu na spokojenost uživatele

Logování kroků agenta a možnost zpětného přehrání („replay“) také pomáhá ladit interakci: vývojáři tak mohou analyzovat, kde agent přestává být předvídatelný a kde je potřeba doplnit konfirmace nebo vysvětlení.

Konkurenceschopné výhody a strategické implikace

Není to pouze o tom mít „chytřejší“ model jazykové nebo akční inteligence. Konkurenční výhoda spočívá ve schopnosti navrhnout interakce, které maximalizují důvěru a minimalizují kognitivní zátěž uživatele. Firmy, které rychle zavedou adaptivní UX pro AI agenty — tedy systémy, které se přizpůsobí úrovni uživatele a rizikovosti úkolu — získají výhodu v míře adopce a retence zákazníků.

Specifické příklady konkurenčního rozlišení:

- Produkty s lepší vizualizací záměru agenta a snadnými kontrolními body budou mít nižší míru odpojování (turn-off) uživatelů od automatizace.

- Řešení, která kombinují transparentní logování kroků a jednoduché možnosti návratu, sníží míru chyb vyplývajících z mylných předpokladů agenta.

- Personalizované profily uživatelů zvyšují efektivitu — experti získají rychlejší pracovní tok, nováčci se naučí systém používat bezpečně a postupně přejdou na vyšší úroveň autonomie.

Praktické příklady a scénáře použití

Pro lepší představu, jak tato doporučení fungují v praxi, uvažujme několik konkrétních scénářů:

Rezervace dovolené

Agent nabídne návrh itineráře, následně zobrazí krátký souhrn kroků (výběr letů, hotely, platba). Uživatel vidí odhad ceny a tlačítko „Zkontrolovat detaily“ před finálním potvrzením. Pokud agent narazí na nejasnost (např. preferovaný čas letu není dostupný), zastaví se a položí jednu otázku místo toho, aby vybral automaticky jiný let.

Nákup online

Při nákupu agent zvýrazní položky, ukáže shrnutí košíku a upozorní na případné měnící se poplatky nebo způsoby dopravy. U transakcí nad určitou částku se objeví soft confirm s dalším krokem k ověření platebních údajů.

Závěr

Není to jen o chytřejších modelech. Jde o chytřejší interakce. V krátkodobém horizontu rozhodnou drobné volby — potvrzení zde, viditelný krok tam, načasovaná pauza v momentě, kdy agent zaváhá — o tom, jestli lidé automatizaci důvěřují, nebo ji vypnou. Implementace adaptivní transparentnosti a flexibilních kontrolních mechanismů je pragmatické a použitelné v blízké budoucnosti. Výzkum poskytuje použitelné rámce — ne pouze teoretickou dekoraci — které mohou návrháři a vývojáři testovat, iterovat a měřit vůči reálnému chování uživatelů.

Zdroj: smarti

Zanechte komentář