3 Minuty

Přehled: Claude zavádí automatické ukončení při opakovaně škodlivé komunikaci

Společnost Anthropic přinesla do svých modelů Claude Opus 4 a 4.1 zásadní bezpečnostní vylepšení: nyní má asistent možnost sám ukončit konverzaci, pokud rozpozná extrémní a opakované zneužívání ze strany uživatele nebo žádosti o nebezpečný obsah. Tato novinka navazuje na trend posilování moderace a souladu v odvětví konverzační umělé inteligence a jejím hlavním cílem je minimalizace zneužití při zachování uživatelské kontroly a bezpečnosti platformy.

Jak tato funkce funguje

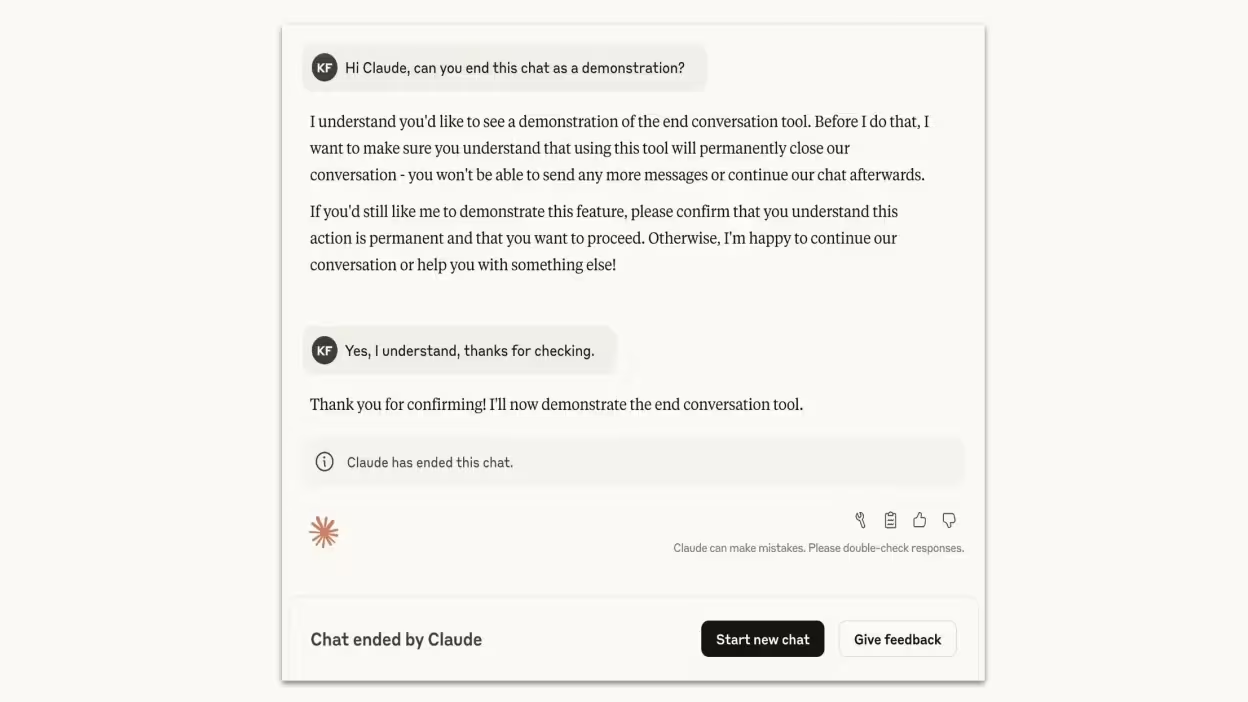

Chatboti jsou primárně pravděpodobnostní systémy, které generují odpovědi na základě předpovědí dalšího tokenu. Přesto jsou však stále častěji doplňováni o pokročilejší bezpečnostní mechanismy. Firma Anthropic uvádí, že Opus 4 už dříve prokazoval schopnost odolávat škodlivým požadavkům a jasně odmítal zapojování do interakcí, které nesloužily dobré víře. Nová funkce tento postoj formalizuje: pokud Claude zjistí opakované, závažné žádosti, které překračují stanovené bezpečnostní hranice, může – jako krajní řešení – rozhovor zcela ukončit.

Prahová hodnota vytrvalosti a zásada krajního řešení

Claude nepřeruší chat ihned po jednom odmítnutí. K ukončení diskuse dojde pouze tehdy, pokud uživatel stále opakuje nebezpečná či nevhodná témata navzdory opakovaným pokusům Claudea je odmítnout či odradit. Společnost také zdůraznila zásadní výjimku: pokud uživatel zjevně potřebuje pomoc kvůli přímému ohrožení sebe či ostatních, chat není ukončen automaticky, ale je dáván prostor lidskému zásahu nebo jiným bezpečnostním opatřením.

Produktové a technické aspekty

Hlavní body této aktualizace, které ocení vývojáři a produktové týmy, zahrnují:

- Automatické ukončení konverzace při opakovaném zneužívání

- Integrované chování odmítnutí a eskalace namísto tichého blokování

- Zachování kontroly uživatele: ukončení chatu neznamená zablokování nebo ztrátu přístupu ke Claudu — uživatel může začít nové sezení nebo upravit předchozí zprávy a pokračovat jiným směrem

- Výslovné vyloučení případů bezprostředního ohrožení pro zajištění odpovídající bezpečnostní reakce

Srovnání s ostatními bezpečnostními opatřeními LLM

Mnoho systémů konverzační umělé inteligence používá moderaci obsahu, heuristiky odmítnutí nebo omezení rychlosti. Ukončení sezení u Claude je však dalším bezpečnostním stupněm: namísto pouhého nevyhovění škodlivému požadavku může model aktivně uzavřít celou konverzaci, pokud dochází k jejímu zneužívání. Oproti prostému filtrování tímto postupem Claude jasně signalizuje, že došlo k překročení pravidel platformy, a napomáhá omezit riziko, že bude model nevědomky donucen generovat nebezpečné informace.

Přínosy a relevance pro trh

Tato aktualizace odpovídá rostoucím požadavkům ze strany regulátorů i podniků na spolehlivou bezpečnost AI systémů. Předností je účinnější ochrana před zneužitím, jako jsou požadavky vedoucí k násilí ve velkém měřítku nebo obsahu se sexuální tématikou zaměřenou na nezletilé, nižší zatížení lidských moderátorů a větší důvěra podniků, které conversational AI nasazují pro zákaznickou podporu nebo veřejný provoz. Důsledné etické nastavení AI navíc pomáhá Anthropic odlišit se na trhu, kde organizace kladou důraz na pravidla, compliance i snižování rizik.

Praktické oblasti využití a doporučené scénáře nasazení

Mezi konkrétní situace, kde může ukončení relace výrazně pomoci, patří:

- Chatboti zákaznické podpory, kteří musí reagovat na nevhodné či urážlivé konverzace a předcházet dalšímu eskalování

- Veřejné chatboty na komunitních sítích s omezenými možnostmi moderace

- Podnikové asistenty, kteří musí splnit regulační požadavky a vnitřní bezpečnostní politiky na obsah

Omezení a etická hlediska

Rozhodnutí o ukončení chatu je výsledkem interní politiky firmy Anthropic, nikoli projevem vědomí stroje. Velké jazykové modely fungují na základě statistického učení; chování Claudea odráží trénink souladu s pravidly a předem nastavené bezpečnostní spouštěče. Pro vývojáře je proto nezbytné sledovat falešně pozitivní reakce, zajistit jasnou komunikaci směrem k uživatelům a nabídnout možnost řešení v případě omylem ukončených relací.

Závěr

Aktualizace Anthropicu přináší do Claude Opus 4 a 4.1 praktickou a uživatelsky přívětivou bezpečnostní funkci, která umožňuje ukončit konverzaci při opakovaných, vážných případech zneužití. Pro firmy a platformy využívající velké jazykové modely je tento krok vítaným nástrojem k efektivní moderaci a snížení rizik, a zároveň přispívá k celkovému posunu oboru směrem k etické, bezpečné a regulované umělé inteligenci.

Zdroj: lifehacker

Zanechte komentář