8 Minuty

Úvod

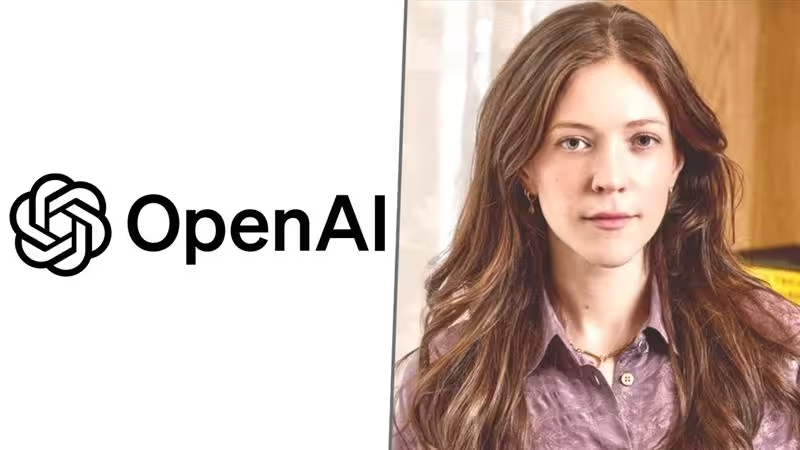

Kdo vytahuje zástrčku, když interní politika naráží na ambice produktu? U OpenAI se tato otázka v zimě stala předmětem hlaviček zpráv poté, co náhle odešel Ryan Beiermeister, viceprezident společnosti pro produktovou politiku.

Pozadí případu

Podle zprávy Wall Street Journal byl v lednu propuštěn poté, co jej měl údajně obvinit mužský kolega ze zaujatosti na základě pohlaví. Beiermeister toto obvinění popírá. „To tvrzení, že jsem někoho diskriminoval, je prostě nepravdivé,“ řekl v krátkém prohlášení pro Journal.

Časování a kontext

Propouštění vzbudilo zvýšenou pozornost zejména proto, že přišlo v době debaty o plánované funkci ChatGPT označované jako „režim pro dospělé“. Fidji Simo, vedoucí spotřebitelských aplikací v OpenAI, novinářům již sdělila, že uvedení funkce je plánováno na první čtvrtletí. Tento časový rámec vyvolal zvýšenou pozornost jak uvnitř firmy, tak mimo ni.

Rozdílné názory uvnitř společnosti

Beiermeister a další podle zpráv s plánem nesouhlasili. Co je trápilo? Jak by explicitní nebo permisivní režim mohl ovlivnit zranitelné uživatele a bezpečnostní zábrany společnosti. Jde o kompromisy: z jedné strany poptávka uživatelů po menších omezeních, z druhé riziko, že uvolnění kontrol vystaví lidi škodě. Je to klasické dilema produkt versus politika, ale hráté ve firmě, jejíž nástroje ovlivňují to, co miliony lidí vidí a slyší online.

Oficiální stanovisko OpenAI

OpenAI popisuje Beiermeisterův odchod jako nesouvisející s politickými otázkami, které řešil. Společnost uvedla, že byl na dovolené a že během svého působení přispěl hodnotnou prací. Přesto načasování vyvolalo spekulace. Když vnitřní neshody o vysoce profilovaných změnách produktu souhlasí s náhlými personálními změnami, pozorovatelé přirozeně zvažují příčinu a následek.

Profesní zkušenosti a vliv

Beiermeisterův profesní životopis vysvětluje, proč jeho hlas uvnitř organizace měl váhu. Jeho profil na LinkedIn uvádí přibližně čtyři roky v produktovém týmu společnosti Meta a více než sedm let v Palantiru — zkušenosti, které kombinují návrh produktů s provozní a etickou složitostí. Toto pozadí pravděpodobně formovalo jeho skepsi vůči širokému, nefiltrovanému chatovacímu režimu.

Produktová politika versus obchodní tlak

OpenAI vyrovnává tlak z několika směrů: regulátoři požadující bezpečnější umělou inteligenci, uživatelé žádající více kontroly a vedení firmy soutěžící o rychlé uvedení konkurenčních funkcí. Když se tyto síly střetnou, výsledek je často nevyrovnaný. Personální změny se stáčejí do veřejné roviny, prohlášení se analyzují kvůli skrytému smyslu a důvěra — vnitřní i vnější — je podrobena zkoušce.

Praktické kompromisy v designu

V návrhu funkcí, jako je „režim pro dospělé“, se řeší následující technické a etické dilemata:

- Moderace obsahu versus svoboda projevu: Jaké limity zavést, aby systém nezpřístupnil škodlivý obsah, aniž by nadměrně cenzuroval legitimní komunikaci?

- Věkové ověřování a souhlas: Jak spolehlivě ověřit věk uživatele, aniž by se porušila soukromí nebo se vytvořila vysoká bariéra užití?

- Bezpečnostní ochranné prvky: Které filtry a detekční modely jsou nutné k minimalizaci rizika pro zranitelné skupiny?

- Řízení rizik a právní odpovědnost: Jaké právní a regulační závazky se vztahují na explicitní obsah v různých jurisdikcích?

Technická řešení a bezpečnostní přístupy

Aby minimalizovaly rizika spojená s permisivnějšími režimy, technologické firmy zvažují kombinaci technických opatření a provozních procesů. Některé z těchto přístupů jsou:

Vícevrstvá filtrace a moderace

Provozovat více úrovní obsahu detekce: od jednoduchých pravidel přes strojové učení až po lidské přezkoumání v kombinaci s kontextovými signály (např. profil uživatele, předchozí chování). To umožňuje jemnější rozhodování o tom, kdy je uživateli povoleno více explicitní odpovědi a kdy je nutné intervenovat.

Jemně nastavitelné uživatelské preference

Umožnit uživatelům volit úroveň explicitního obsahu v rámci bezpečných limitů. Takové preference by měly být doprovázeny jasnými varováními, ověřováním věku a možnostmi promehání (opt-in/opt-out) s auditní stopou pro případné kontroly.

Techniky řízení rizik

Zavádění mechanismů jako harm scoring (skóre rizika), red-teamování (interní i externí testy útoků na systém), a průběžná telemetrie chování modelu, která upozorní inženýry a politiky na nečekané trendy nebo zneužití.

Dopad na důvěru, regulaci a průmyslové standardy

To, jak OpenAI zareaguje na konflikt mezi produktovou ambicí a firemní politikou, bude mít širší důsledky pro celý sektor. Pár klíčových oblastí dopadu:

- Regulace: Regulátoři budou pozorně sledovat, zda firmy aktivně řeší bezpečnost AI a implementují opatření zmírňující újmu. Případy v médiích mohou urychlit právní rámce či doporučení regulačních orgánů.

- Průmyslové standardy: Rozhodnutí jedné významné firmy často fungují jako precedens pro ostatní. Pokud OpenAI zvolí přísnější přístupy, může to zvýšit tlak na konkurenty, aby implementovali podobné bezpečnostní prvky.

- Důvěra veřejnosti: Věrohodnost společnosti je úzce svázána s transparentností rozhodnutí, se způsoby řešení incidentů a se schopností vysvětlit kompromisy mezi funkcionalitou a bezpečností.

Role vedení a governance

Rozhodování o produktech, která zasahují do veřejného diskurzu, vyžaduje jasnou governance: definované odpovědnosti mezi produktovým vedením, týmem pro politiky, právním oddělením a bezpečnostními experty. Bez pevné struktury se riziko rozhodnutí na základě krátkodobých obchodních impulsů zvyšuje.

Etika, odpovědnost a podniková kultura

Spory jako ten kolem „režimu pro dospělé“ nejsou jen technické nebo právní — jsou hluboce etické. Firmy, které vyvíjejí konverzační AI, musejí nastavit kulturu, jež podporuje otevřený dialog, respekt k diverzitě názorů a mechanismy pro řešení konfliktů, aniž by to ohrozilo výkonnost nebo agilitu produktového vývoje.

Ochrana zranitelných skupin

Osobní bezpečnost zranitelných uživatelů — například mladistvých, obětí domácího násilí nebo osob s duševním onemocněním — musí být klíčovým faktorem při navrhování produktů. Praktická ochrana může znamenat výchozí tvrdší nastavení, speciální filtry nebo upozornění pro moderátory v rizikových scénářích.

Možné scénáře dalšího vývoje

Několik realistických scénářů, jak by se situace mohla vyvinout:

- OpenAI uvede „režim pro dospělé“ s rozsáhlými bezpečnostními kontrolami, ověřováním věku a možnostmi reportování — kompromis mezi funkcí a bezpečností.

- Společnost odloží nebo zcela zruší uvedení funkce po interní revizi a konzultacích s předními bezpečnostními experty a regulátory.

- Funkce je postupně zaváděna v omezeném pilotním režimu v několika jurisdikcích, zatímco se sbírají data o dopadech a zlepšují se filtry.

Doporučení pro firmy v podobné situaci

Několik doporučení pro organizace, které stojí před obdobnými rozhodnutími:

- Zavést jasné governance procesy pro konfliktní rozhodnutí mezi politikou a produktem.

- Provádět důkladné red-team testy a zapojit externí poradce pro etiku a bezpečnost.

- Komunikovat transparentně s veřejností o rizicích, kompromisech a opatřeních pro ochranu uživatelů.

- Monitorovat dopady funkcí pomocí metrik bezpečnosti a zapojení uživatelů a být připraven rychle upravit strategii.

Co je zatím veřejně známo a co zůstává soukromé

Do této chvíle zůstávají podrobnosti obvinění z diskriminace neveřejné nad rámec počátečních zpráv. Konflikt kolem „režimu pro dospělé“ je ale zřejmý: firma se potýká s tím, kde stanovit hranice mezi svobodou a odpovědností při škálování konverzační AI na stále větší publikum.

Veřejný zájem a investigace

Média a zájmové skupiny budou pokračovat v monitoringu rozhodnutí OpenAI kvůli jejich širším dopadům na bezpečnost AI, moderaci obsahu a právní odpovědnost. Transparentní procesy a zveřejnění výsledků interních auditu může zmírnit spekulace a obnovit důvěru.

Závěr

Jak OpenAI odpoví na tuto otázku, ovlivní nejen jeden produkt, ale také standardy, kterými se bude odvětví řídit, když se produktová ambice a firemní politika dostanou do konfliktu. Vyvážení inovace s ochranou uživatelů, dodržování předpisů a udržení důvěry veřejnosti bude klíčové pro dlouhodobý úspěch firem pracujících s konverzační AI.

Rozhodnutí ohledně „režimu pro dospělé“ a související interní spory slouží jako případová studie: jak se firmy, regulátoři a společnost obecně budou učit nastavovat pravidla pro bezpečné a odpovědné využití umělé inteligence v praxi.

Zdroj: smarti

Zanechte komentář